元注解

java.lang.annotation提供了四种元注解,专门注解其他的注解(在自定义注解的时候,需要使用到元注解):

Retention 定义该注解的生命周期

RetentionPolicy.SOURCE: 在编译阶段丢弃。这些注解在编译结束之后就不再有任何意义,所以它们不会写入字节码。@Override,@SuppressWarnings都属于这类注解。RetentionPolicy.CLASS: 在类加载的时候丢弃。在字节码文件的处理中有用。注解默认使用这种方式RetentionPolicy.RUNTIME: 始终不会丢弃,运行期也保留该注解,因此可以使用反射机制读取该注解的信息。我们自定义的注解通常使用这种方式。

Target 表示该注解用于什么地方。默认值为任何元素,表示该注解用于什么地方。可用的ElementType参数包括

ElementType.CONSTRUCTOR:用于描述构造器ElementType.FIELD:成员变量、对象、属性(包括enum实例)ElementType.LOCAL_VARIABLE:用于描述局部变量ElementType.METHOD:用于描述方法ElementType.PACKAGE:用于描述包ElementType.PARAMETER:用于描述参数ElementType.TYPE:用于描述类、接口(包括注解类型) 或enum声明

Documented 一个简单的Annotations标记注解,表示是否将注解信息添加在java文档中

Inherited 元注解是一个标记注解,@Inherited阐述了某个被标注的类型是被继承的。如果一个使用了@Inherited修饰的annotation类型被用于一个class,则这个annotation将被用于该class的子类

自定义注解

自定义注解类编写的一些规则: Annotation型定义为@interface, 所有的Annotation会自动继承java.lang.Annotation这一接口,并且不能再去继承别的类或是接口. 参数成员只能用public或默认(default)这两个访问权修饰 参数成员只能用基本类型byte,short,char,int,long,float,double,boolean八种基本数据类型和String、Enum、Class、annotations等数据类型,以及这一些类型的数组. 要获取类方法和字段的注解信息,必须通过Java的反射技术来获取 Annotation对象,因为你除此之外没有别的获取注解对象的方法 注解也可以没有定义成员, 不过这样注解就没啥用了 PS:自定义注解需要使用到元注解

1 |

|

注解的原理

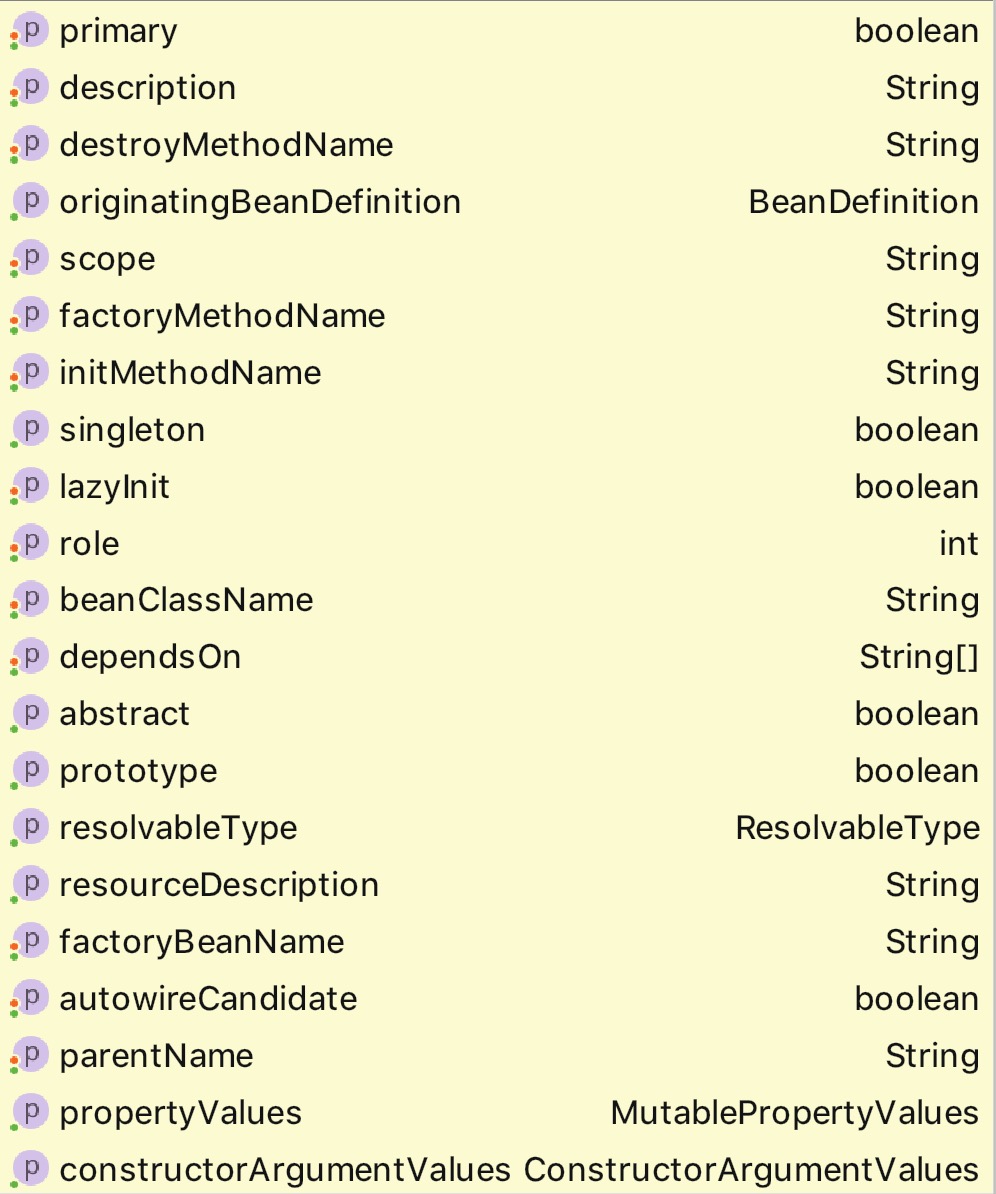

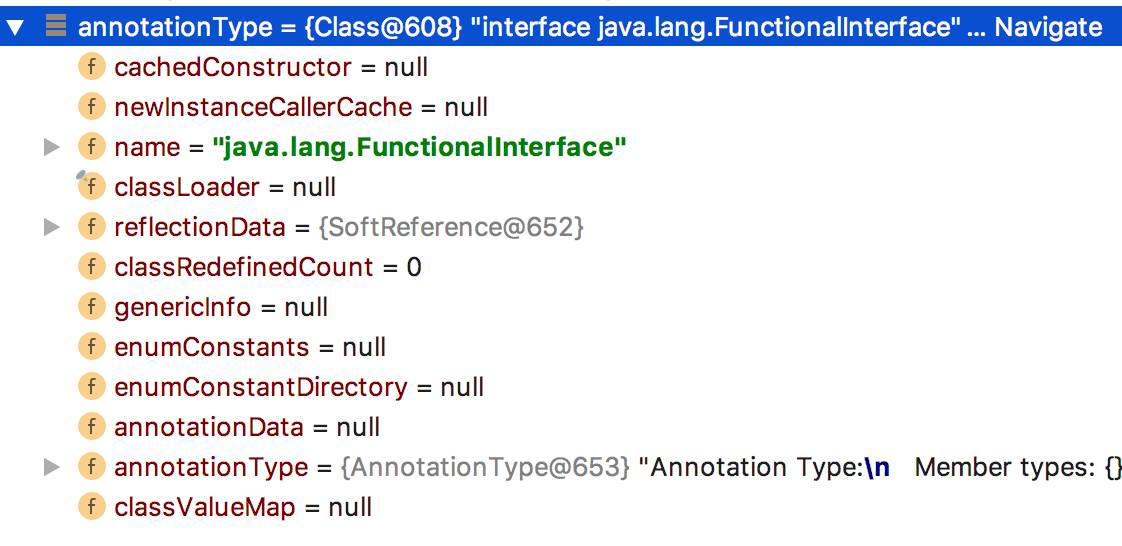

注解本质是一个继承了Annotation的特殊接口,其具体实现类是Java运行时生成的动态代理类。而我们通过反射获取注解时,返回的是Java运行时生成的动态代理对象$Proxy1。通过代理对象调用自定义注解(接口)的方法,会最终调用AnnotationInvocationHandler的invoke方法。该方法会从memberValues这个Map中索引出对应的值。而memberValues的来源是Java常量池。

通过示例我们可以看出代理类,我们可以使用annotationType()方法来获取实际的注解类

1 | FunctionalInterface functionalInterface = Function.class.getAnnotation(FunctionalInterface.class); |

proxy = class com.sun.proxy.$Proxy1 annotationType = interface java.lang.FunctionalInterface

所有 class 的 class,即 Class 类中,有关于 annotation 的属性annotationData,annotationType,因所有 class 都是Class的实例,所以所有 class 都会包含这些有关 annotaion 的属性。这就是为什么所有的 class 都可以使用getAnnotations()等方法

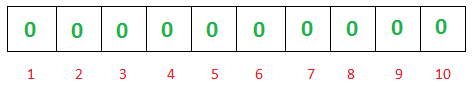

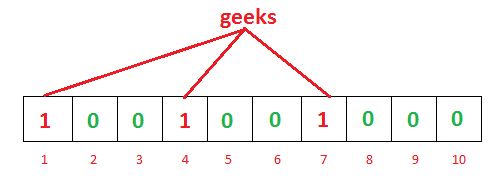

如果我们要映射一个值到布隆过滤器中,我们需要使用多个不同的哈希函数生成多个哈希值,并对每个生成的哈希值指向的 bit 位置 1,比如针对值

如果我们要映射一个值到布隆过滤器中,我们需要使用多个不同的哈希函数生成多个哈希值,并对每个生成的哈希值指向的 bit 位置 1,比如针对值 而当我们需要查询

而当我们需要查询